NVIDIA ジェンスン・フアンCEO、CES 2026でフィジカルAIの本格展開を宣言

次世代GPU「Vera Rubin」と自動運転AI「Alpamo」、ワールド基盤モデル「Cosmos」を発表

NVIDIAは2026年1月6日(現地時間)、米ラスベガスで開催中のCES 2026において基調講演を行い、次世代GPUアーキテクチャ「Vera Rubin(ヴェラ・ルービン)」、世界初の推論型自動運転AI「Alpamo(アルパモ)」、ワールド基盤モデル「Cosmos」の本格展開など、多岐にわたる新技術・新製品を発表した。

「2つのプラットフォームシフトが同時に起こっている」

ジェンスン・フアンCEOは冒頭に「これまで10~15年ごとにコンピュータ業界はメインフレーム、PC、インターネット、クラウド、モバイルと進化してきたが、今回は2つのプラットフォームシフトが同時に起きている」と語った。

AIがアプリケーションの上に成り立つのではなく、今後はAIの上にアプリケーションが構築されるとし、「ソフトウェアはプログラミングではなくトレーニングするものになり、CPUでなくGPUで実行する。アプリケーションはその場ごとにゼロから完全に自動生成される」と、コンピューティング全体の大転換を強調した

Vera Rubin:6チップ同時刷新でBlackwell比最大10倍の性能向上

基調講演の目玉となったのが、次世代アーキテクチャ「Vera Rubin」だ。銀河の回転速度からダークマター(暗黒物質)の存在を示唆した天文学者ヴェラ・ルービンにちなんで命名された。

注目すべきは、NVIDIAが6つの異なるチップを同時に刷新したことだ。フアンCEOは「通常は1世代に1〜2個の変更だが、今回はすべてのチップを再設計した。ムーアの法則が減速する中、トランジスタ数だけでは毎年10倍というモデル拡大に追いつけない」と、極端な協調設計(Co-design)の必要性を説明した。

主要コンポーネントの概要は以下の通りだ。

Vera CPUは、電力制約のある環境で従来比2倍のパフォーマンスを実現する。Rubin GPUは、Blackwell比で5倍の浮動小数点性能を達成した。トランジスタ数は1.6倍増にとどまるが、動的かつ適応的に精度を調整する新技術「NVFP4 Tensor Core」によってこの飛躍を可能にした。

NVL72 Rubinは、ケーブルレス設計と100%液冷を採用。45℃の温水での冷却が可能で、組み立て時間を従来の2時間から5分へと大幅に短縮した。NVLink 6 Switchは「世界のインターネットデータの2倍の量を、2倍の速度で移動させる」性能を持つ。

BlueField-4は、従来のセキュリティや仮想化のオフロードに加え、新たな用途として「KVキャッシュ・コンテキストメモリストア」を実現する。フアンCEOは「長い会話、長いリサーチを行うと、コンテキストメモリはHBMに収まらなくなる。ネットワーク越しにストレージに取りに行くと遅すぎる」と課題を説明。各BlueFieldの後ろに150テラバイトのメモリを配置し、各GPUは追加で16テラバイトのメモリを高速に利用できるようになる。

ベンチマークでは、10兆パラメータモデルのトレーニングでBlackwell比4倍、データセンターのファクトリースループットで10倍、トークン生成コストは10分の1になるという。

Alpamo:世界初の「思考する自動運転AI」をオープンソースで公開

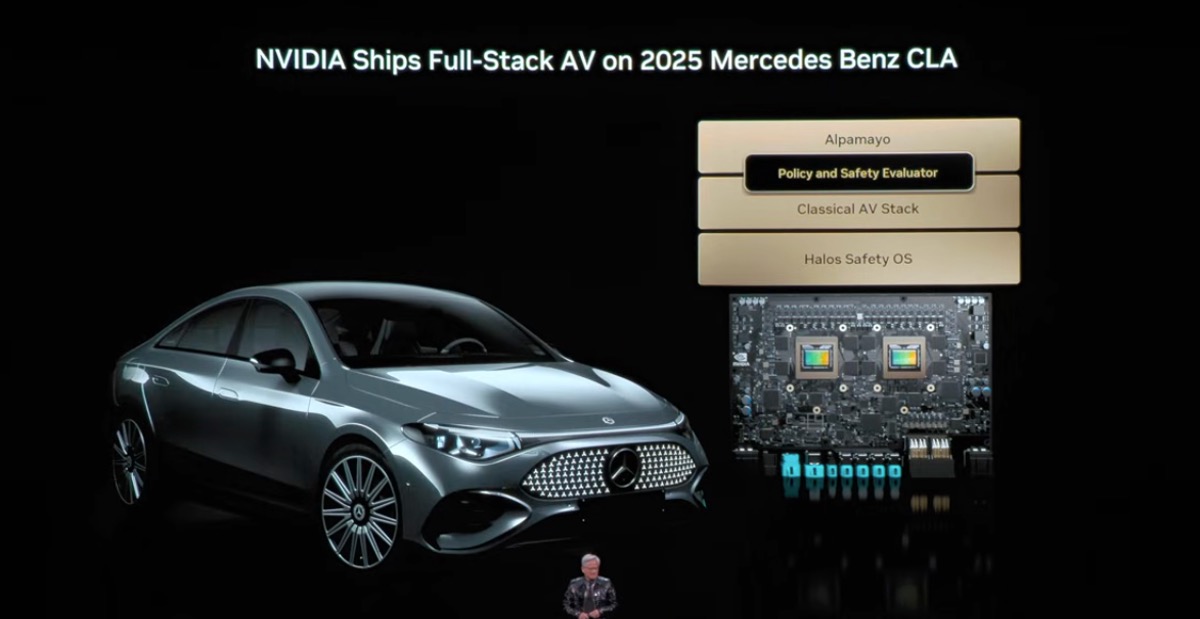

物理AI分野では、自動運転AI「Alpamo」が発表された。フアンCEOはこれを「世界初の思考し、推論する自動運転車AI」と位置づけた。

NVIDIAは8年前に自動運転車の開発を開始。フアンCEOは「ディープラーニングとAIがコンピューティングスタック全体を再発明すると推論したからだ」と振り返った。

Alpamoの特徴は、エンドツーエンドでトレーニングされている点だ。カメラ入力からアクチュエーション(動作)出力まで直結しており、人間によるデモンストレーションと、ワールド基盤モデル「Cosmos」によって生成された大量の合成データから学習する。

従来の自動運転システムとの決定的な違いは、Alpamoが「これから取る行動とその理由、そして軌道を推論する」点にある。ロングテールのシナリオ(稀な状況)を、通常の状況に分解して推論することで対応する。

NVIDIAはAlpamoをオープンソースとして公開するだけでなく、トレーニングに使用したデータも公開する。フアンCEOは「モデルがどのようにして生まれたかを真に信頼できるようにするため」と理由を説明した。

メルセデス・ベンツとの提携による最初の搭載車両は、2026年第1四半期に路上走行を開始する予定だ。同車両はNCAPで世界最高の安全評価を獲得しており、すべてのコード行、チップ、システムが安全性認定を受けている。安全性担保のため、Alpamoスタックと従来型AVスタックの2系統を搭載し、自信がない場合は従来型にフォールバックする設計となっている。

Cosmos:物理世界を理解するワールド基盤モデル

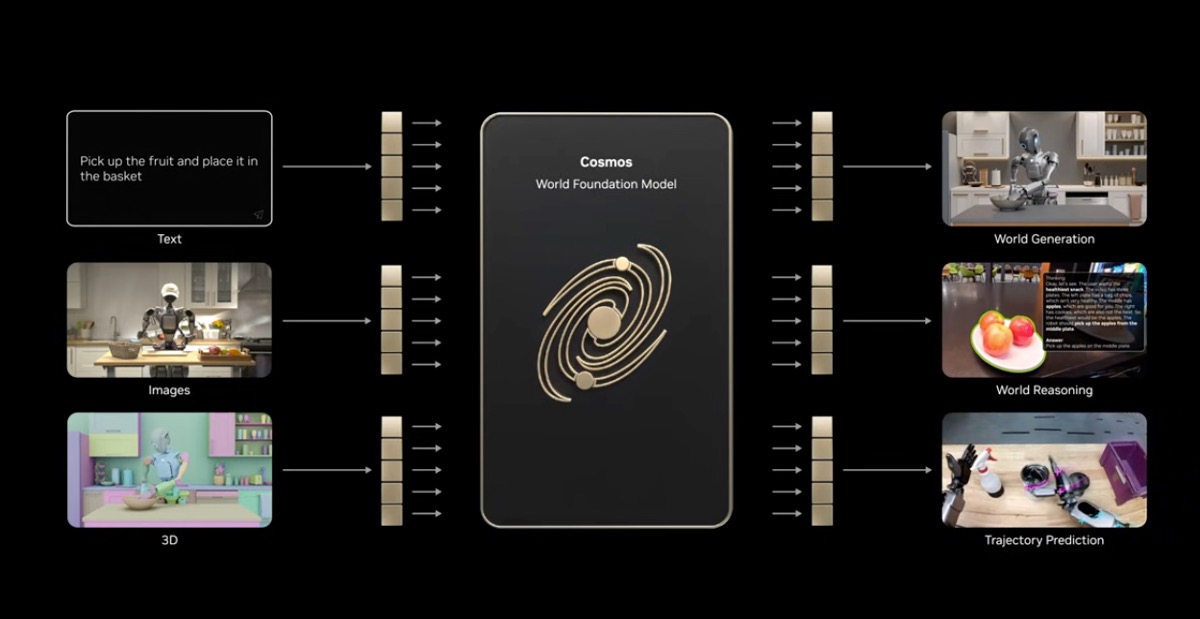

Alpamoの学習を支えるのが、ワールド基盤モデル「Cosmos」だ。フアンCEOは「言語の基盤モデルではなく、世界の基盤モデル」と表現した。

Cosmosは、物理法則によって条件付けられた合成データ生成を行う。交通シミュレーターの出力をCosmosに入力することで、物理的に正確なサラウンドビデオを生成し、AIの学習データとして活用できる。画像から未来を予測したり、3Dシーン記述からリアルなビデオを生成したり、エッジケースをシミュレーションする能力を持つ。

NVIDIAは物理AIには「トレーニング用コンピュータ」「推論用コンピュータ」「シミュレーション用コンピュータ」の3つが必要だとし、Omniverseによるデジタルツイン、Cosmos、Groot(ヒューマノイドロボット)やAlpamoを統合的に展開していく方針を示した。

エージェンティックAIフレームワーク「Blueprint」

ソフトウェア面では、エージェンティックAIフレームワーク「Blueprint」の展開を発表した。

フアンCEOは「2025年にエージェンティック・システムが登場し、あらゆる場所に普及し始めた。推論し、情報を調べ、ツールを使用し、未来を計画し、結果をシミュレーションする能力を持つ」と述べた。推論能力について「問題をステップに分解し、これまでトレーニングされたことのないことを実行するためにステップを構成する能力。これが推論の素晴らしい能力だ」と説明した。

Blueprintは、プロプライエタリなフロンティアモデルとカスタマイズされたローカルモデルを組み合わせ、意図ベースのルーターで適切なモデルに振り分ける設計だ。プライバシーが求められる処理はローカルで、高度な推論が必要な処理はフロンティアモデルで処理できる。

このフレームワークは、Palantir、ServiceNow、Snowflake、CrowdStrike、NetAppなど世界有数のエンタープライズプラットフォームに統合される。フアンCEOは「これがアプリケーションの開発方法であるだけでなく、プラットフォームのユーザーインターフェースになる。エージェンティックなシステムがインターフェースになる」と述べた。

Siemensとの提携で産業全体に物理AIを展開

産業分野では、Siemensとの大規模提携が発表された。CUDA-X物理AI、エージェンティックAI、Nemo、NemotronをSiemensのプラットフォームに統合し、設計からシミュレーション、生産、運用まで産業のライフサイクル全体に物理AIをもたらす。

フアンCEOは「NVIDIAとSiemensによる新しい産業革命、物理AIの時代だ」と宣言した。Omniverseツールを使えば、コンクリートを流し込む前に仮想世界で工場を建設・デバッグでき、製造施設の建設がより速く安価になるという。

オープンモデルへのコミットメント

フアンCEOは講演を通じて、オープンモデルへの強いコミットメントを示した。

「2025年に起こった最も重要なことの一つが、オープンモデルの進歩だ」と述べ、DeepSeek R1を「最初のオープンな推論モデル。世界を驚かせ、このムーブメント全体を活性化させた本当に素晴らしい仕事」と高く評価した。

NVIDIAが開発し公開しているモデルとして、Llama Protina(タンパク質生成)、OpenFold 3(タンパク質構造理解)、Nemotron(ハイブリッドTransformer-SSMモデル)、Cosmos、Groot(ヒューマノイドロボット)などを紹介。「すべての企業、産業、国がAI革命に参加できるように、完全にオープンに構築している」と強調した。

製品ロードマップと今後の展望

フアンCEOは「1年半前にGB200を出荷した。今はGB300のフル生産中だ。そして今年、Vera Rubinがフル生産に入っている」と製品ロードマップを説明。「これが今日のNVIDIAだ。チップだけでなく、システム全体、AIスタック全体を構築している」と述べた。

AIのスケーリング則についても言及し「モデルは毎年10倍、桁違いに大きくなっている。推論は今や思考プロセスであり、テストタイム・スケーリングによりトークン数は毎年5倍に増えている」と、計算需要の急増を説明した。

CES 2026でのNVIDIAの発表は、単なる半導体の性能向上にとどまらず、AIインフラからアプリケーション開発手法、産業全体のデジタル化まで包括的なビジョンを示すものとなった。エンタープライズIT部門にとっては、BlueprintフレームワークによるエージェンティックAIの導入、物理AIによる製造・運用の効率化、オープンモデルを活用したカスタムAI構築など、検討すべき選択肢が大幅に広がった。NVIDIAはAI時代のフルスタックプラットフォーマーとしての地位を一層強固にしようとしている。

【出典】NVIDIA公式YouTubeチャンネル:https://www.youtube.com/watch?v=0NBILspM4c4

この記事は参考になりましたか?

- この記事の著者

-

AIdiver編集部(エーアイダイバーヘンシュウブ)

「AIdiver」(エーアイダイバー)は、株式会社翔泳社が運営する、企業およびビジネスパーソンのAIの利活用にフォーカスしたメディアです。経営、ビジネス、日々の業務をAIで変革したい「AIリーダー」の皆さまに役立つコンテンツを発信します。

※プロフィールは、執筆時点、または直近の記事の寄稿時点での内容です